NRIセキュア、生成AIを活用したシステム向けのセキュリティ診断サービス「AI Red Team」を提供開始

発表日:2023年12月18日

NRIセキュア、生成AIを活用したシステム向けのセキュリティ診断サービス「AI Red Team」を提供開始

リスクベースアプローチで大規模言語モデル(LLM)とシステム全体を2段階で診断

NRIセキュアテクノロジーズ株式会社(本社 : 東京都千代田区、代表取締役社長 : 建脇 俊一、以下「NRIセキュア」)は、「AIセキュリティ統制支援」サービスのラインナップの一つとして、新たに生成AIを利用するシステムやサービスを対象にした、セキュリティ診断サービス「AI Red Team(以下、本サービス)」の提供を本日開始します。

■AIが抱えるセキュリティ上の問題点

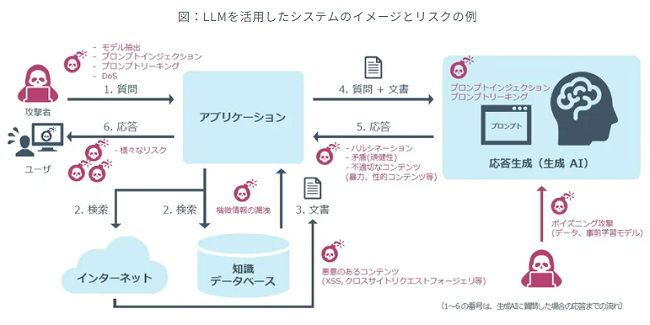

近年、多くの分野で生成AI、とりわけ大規模言語モデル(LLM)[i]の利用が増加の一途をたどっています。LLMへの期待が高まる一方で、LLMには、「プロンプトインジェクション」[ii]、「プロンプトリーキング」[iii]と呼ばれる脆弱性や、「ハルシネーション」[iv]、「機微情報の漏洩」、「不適切なコンテンツの生成」、「バイアスリスク」[v]といったリスクが存在することが浮き彫りになってきました(図を参照)。LLMを利活用する企業は、これらの問題を把握し、適切な対策を施す必要があります。昨今、生成AIを用いたシステムやサービスに特化したセキュリティ診断の重要性が叫ばれており、諸外国では独立した外部の専門家による診断の必要性について言及され始めています。

●図 : LLMを活用したシステムのイメージとリスクの例

コメント

この記事へのトラックバックはありません。

この記事へのコメントはありません。